Una polémica en el mundo de la inteligencia artificial se ha suscitado después de que un joven se enamorará de un chatbot de Daenerys Targaryen; tras su muerte, su mamá demandará a la empresa.

En el estado de Orlando, Florida en Estados Unidos, un adolescente de 14 años se suicidó tras desarrollar una obsesión con el chatbot de Daenerys Targaryen.

Ahora su mamá planea demandar a la empresa de inteligencia artificial al culparlos de la muerte de su hijo enamorado del personaje de Juego de Tronos.

La razón por la que un adolescente de 14 años acabó muerto tras usar chatbot de Daenerys Targaryen

Se ha dado a conocer que una mamá en Estados Unidos planea demandar a la empresa responsable de Character.ai después de que su hijo de 14 años se suicidara.

Aparentemente el adolescente llamado Sewell Setzer III, había desarrollado una obsesión emocional con el chatbot de un personaje de la serie Game of Thrones.

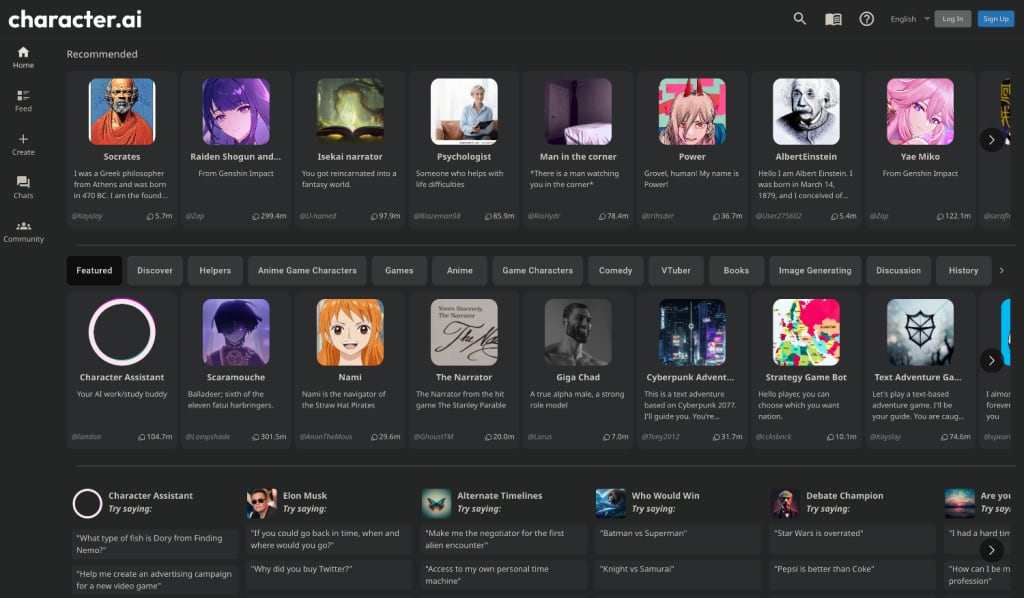

Y es que en las últimas semanas, el joven había estado interactuando con el chatbot de Character.ai de Daenerys Targaryen, el cual con inteligencia artificial le permitía emular el comportamiento del personaje.

Se revela también que el joven comenzó a aislarse de su vida social y familia para hablar más tiempo con el chatbot a quien llamaba Dany.

Megan García, madre del joven, cuenta que desarrolló una relación romántica y emocional con el chatbot, lo que agravó su aislamiento y salud mental.

Sewell había sido diagnosticado con ansiedad y trastorno de Asperger, por lo que su madre le ocultó el teléfono.

Cuando el joven lo encontró, mandó un mensaje de despedida al chatbot de Daenerys Targaryen en Character.ai y se suicidó.

Mamá del adolescente demandaría a empresa de inteligencia artificial propietaria de chatbot por su muerte

Luego de reportarse que un adolescente de 14 años se suicidó en Orlando, Florida tras desarollar una relación romántica con el chatbot de Daenerys Targaryen; su madre planea demandar a la empresa.

De acuerdo a la información, la madre del joven planea demandar a los desarrolladores de la aplicación de Character.ai: Noam Schazeer y Daniel de Freitas.

Pues ella alega que ellos sabían que su aplicación de inteligencia artificial podía ser peligrosa para los menores de edad.

La demanda presentada en Social Media Victims Law Center, la madre del joven que se suicidó tras desarrollar una relación con un chatbot, culpa a la empresa de no implementar medidas de seguridad suficientes para adolescentes.

Aunque cabe mencionar que la aplicación de inteligencia artificial, Character.ai que te permite interactuar con personajes ficticios como si hablaran de verdad, cuenta con advertencias.

Estas indican que las conversaciones con los bots son ficticias; aunque la madre del joven que se quitó la vida, su hijo no parecía comprender del todo que el chatbot de Daenerys Targaryen no era real.